Crawl budget

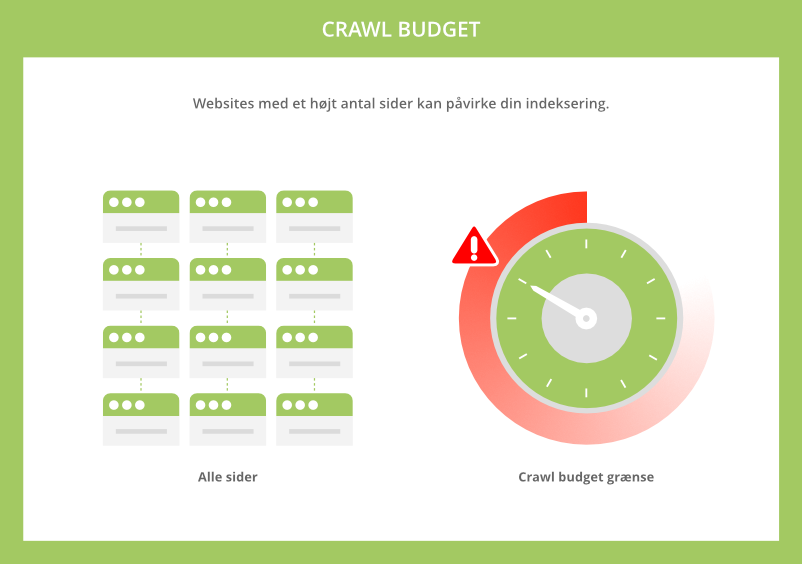

Crawl budget er antallet af sider som Google crawler og indekserer på et website, indenfor en given tidsramme. Optimering af dit crawl budget involverer flere handlinger, der kan forbedre antallet af sider, som Google kan crawle på dit website.

Hvad er crawl budget?

Crawl budget er antallet af sider, som Google vil crawle under en gennemgang af dit website. Hvis antallet af sider overskrider dit websites crawl budget, så vil du have sider på dit website, som ikke bliver indekseret.

Google crawler ikke altid alle sider på et website med det samme. Det kan nogle gange tage uger. Samtidig er der stor forskel på, hvor mange sider googlebot crawler på et given website. Det kan være 10 sider, 1.000 sider eller måske 100.000 sider om dagen. Antallet afhænger af mange forskellige faktorer, som vi vil komme omkring nedenfor.

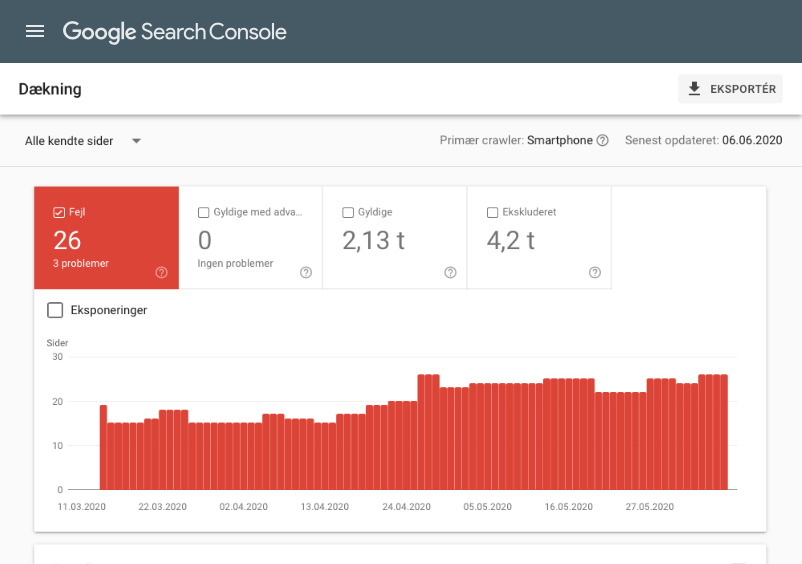

Det skal også nævnes, at dit crawl budget kan variere en smule fra dag til dag. Det er som regel meget stabil. I Google Search Console kan du via den nu forældet crawlstatistik-rapport se, hvor mange sider på dit website, der bliver crawlet pr. dag.

Hvorfor er crawl budget vigtigt for seo?

Kort fortalt: hvis Googlebot ikke crawler en side, så bliver den ikke indekseret og så vil den heller ikke rangere på nogle søgninger. Med andre ord, hvis dit sideantal overgår dit crawl budget, så bliver din synlighed begrænset i Google.

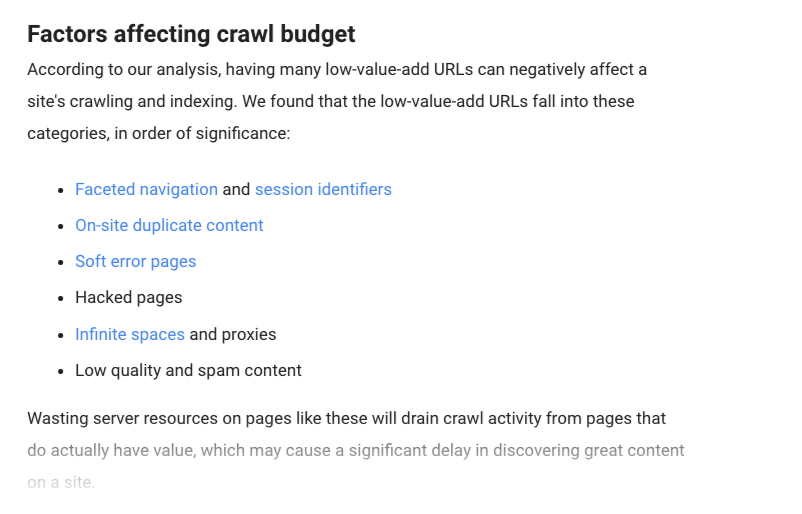

Her hvad Google siger om sagen:

Spild af serverressourcer på [sider med lav værdi] vil dræne crawlaktivitet fra sider, der faktisk har en værdi, hvilket kan forårsage en betydelig forsinkelse på at opdage godt indhold på et website.

Når det er sagt må vi også sige, at det stadig er de færreste websites, som skal bekymre sig om crawlbudgettet. Google er generelt rigtig god til, at finde og indeksere sider. Dog er der nogle enkelte scenarier, hvor du bør fokusere på at optimere det:

- Du har et stort website: Hvis du har et website på over 10.000 sider, så kan Google have svært ved at finde dem alle. Dette gør sig især gældende på ecommerce sites (webshops).

- Du har lige udgivet et stort antal sider: Hvis du for nyligt har udvidet dit website med hundredvis af nye sider. Og har du samtidig et begrænset crawl budget, så kan du optimere det for hurtigere indeksering.

- Du har mange omdirigeringer: Hvis du grundet en dårlig website arkitektur har mange omdirigeringer eller kæder (redirect chains), så kan disse spilde en stor del af dit crawlbudget.

I de næste afsnit an du læse mere om, hvordan du optimerer og maksimerer det.

Sådan optimerer du dit crawl budget

Crawl budget optimering handler om en række trin, som du specifikt kan foretage, der både kan forbedre dit websites helbred og antallet af sider, som Google kan crawle. I de næste afsnit kan du læse mere om, hvad du netop skal have fokus på.

Boost din page speed

Jo hurtigere Google kan crawle dit site, jo bedre. Ved at forbedre din pagespeed, kan du få Googlebot til at crawle flere sider. Google har selv bekræftet dette på deres blog. Omvendt vil langsomme sider spilde den tid, som Googlebot har afsat til dit website.

Sørg for at du følger bedste praksis og minimerer serverfejl, så Google ikke skal bruge tid på, at forsøge at pinge en side, der ikke findes. Forbedringer til din pagespeed kan også have stor indvirkning på dit websites brugeroplevelse (UX) og konvertering.

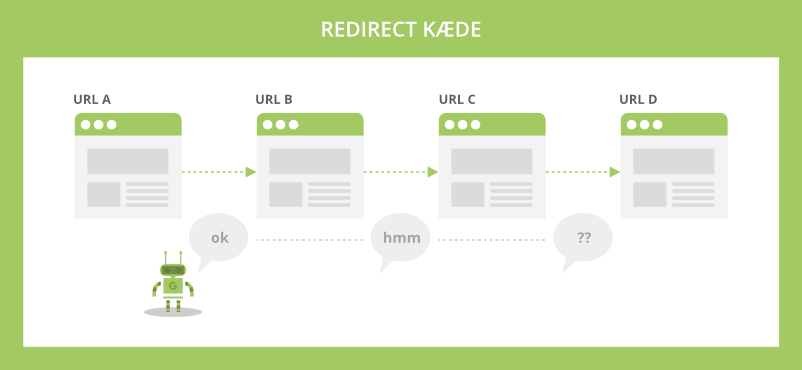

Hold øje med redirect chains

En omdirigeringskæde (redirect chain) opstår, når der er mere end en omdirigering mellem den oprindelige URL og destinationswebadressen. Lange omdirigeringskæder kan have en negativ effekt på Googles crawling.

Jo flere omdirigeringer Googlebot skal igennem, jo større sandsynlighed er der for, at destinationssiden ikke bliver crawlet og indekseret. Samtidig kan destinationssiden risikere et tab i link autoritet, for hver omdirigering (hop) Googlebot skal igennem.

Redirect chains spilder derfor ikke kun dit crawl budget, de kan også begrænse dine siders evne til at blive indekseret og rangere i Google.

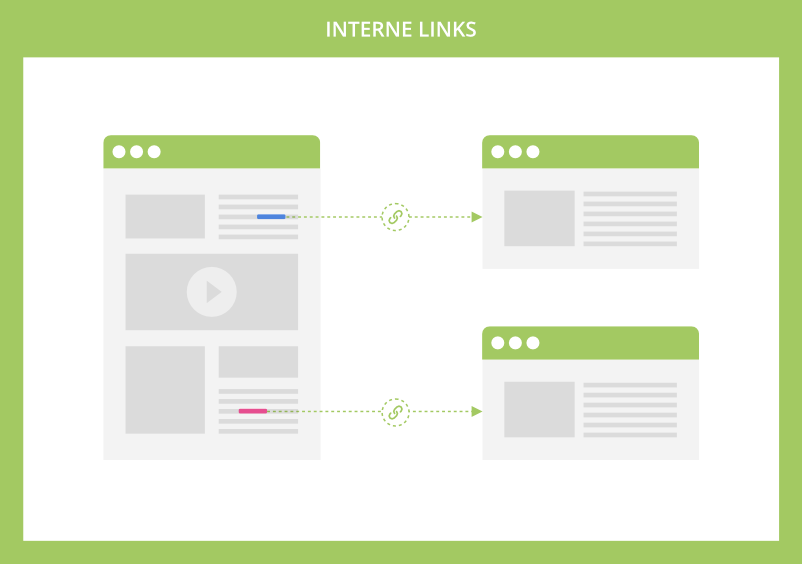

Optimer interne links

Google prioriterer sider som har mange eksterne og interne links, der peger på dem. Der er derfor vigtigt, at du bruger tid på at optimere din interne linkstruktur. Ideelt set bør du have interne og indgående backlinks til alle dine sider, selvom det ofte ikke er realistisk.

Interne links er som vejvisere for dine brugere og Googlebot. Du er derfor nød til at have dem til alle siderne på dit website, som du ønsker fundet og indekseret.

crawlfejl begrænser dit crawl budget

Crawlfejl opstår når søgemaskinerne ikke kan nå en bestemt side på dit website. Det er derfor vigtigt at sikre, at alle dine sider er tilgængelige og returnerer en “200 OK” statuskode, eller omdirigeres til en relevant side, for at undgå crawlfejl.

Google opdeler crawlfejl i 2 hovedkategorier:

- Webstedsfejl: Her er hele dit website utilgængeligt. Det mest almindelige årsager til dette er DNS-fejl, serverfejl eller hvis din robots.txt fil ikke er tilgængelig.

- URL-fejl: Her melder en bestemt URL fejl. Dette kan f.eks. være mobilspecifikke URL-fejl og almindelige 404-fejl, herunder soft 404-fejl.

Crawlfejl begrænser ikke kun dit crawl budget, de skader også brugeroplevelsen. Det er derfor vigtigt, at rydde op i sider, som returnerer en 4xx og 5xx statuskode. En god kilde til at finde disse fejl er Search Console.

Her vil Google også fortælle dig, hvilke sider der skaber hvilke fejl.

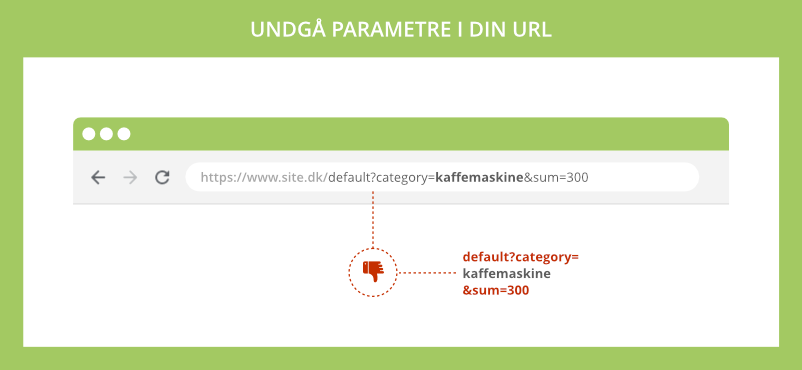

Pas på webadresser med parametre

Fordi webadresser med parametre regnes af crawlere som separate sider, spilder de også dit crawlbudget.

Hvis ikke du kan undvære parametre i dine URL’er, så forsøg i det mindste at begrænse dem. Derudover bør du gøre Google opmærksom på disse URL-parametre, for at undgå, at rejse bekymring over duplicate content.

Udover at bruge kanonisering til håndtering af duplikeret indhold, kan du også gøre Google opmærksom på dine URL-parametre via din Google Search Console-konto.

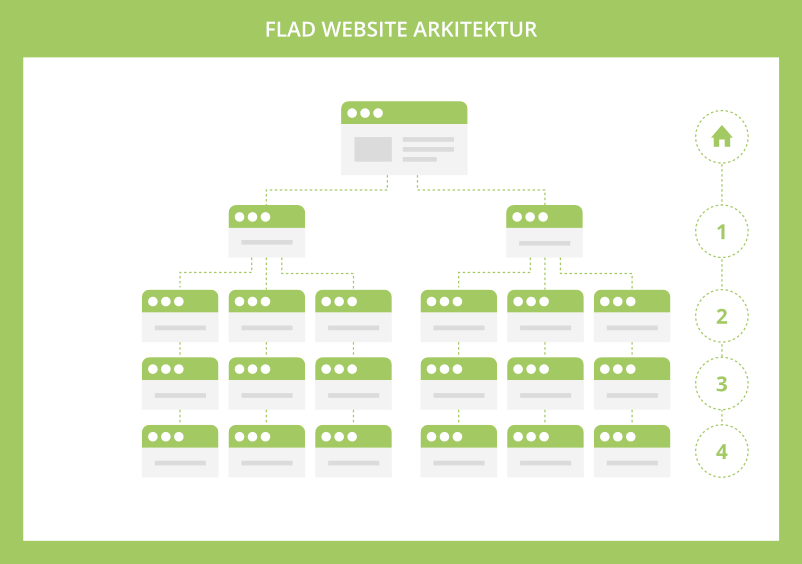

Prioriter en flad website arkitektur

Google har på deres blog sagt, at webadresser der er mere populære på internettet, har tendens til at blive crawlet oftere, med henblik på at holde dem friskere i deres indeks. Og i Googles verden kan popularitet forenes med linkautoritet.

Af samme grund bør du prioritere en flad website arkitektur på dit website, hvor alle sider kan nås indenfor maksimalt 4 klik fra din hjemmeside.

En flad struktur vil også betyde, at der altid flyder en betydelig mængde linkautoritet til alle sider. Dermed indbyder du automatisk Google til, at besøge dine sider oftere.

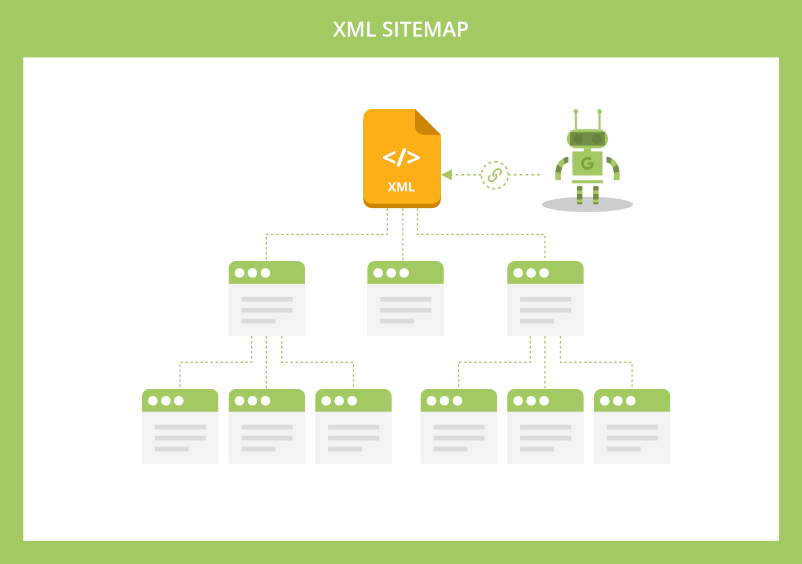

Opdater dit sitemap

At holde dit XML sitemap opdateret og fri for fejl, er afgørende for korrekt crawling af dit website. Sitemappet viser søgemaskinerne, hvordan dit indhold er organiseret og lader dem opdage nyt indhold hurtigere.

Du bør sikre at dit XML sitemap er dynamisk, så det automatisk opdaterer når du tilføjer, fjerner og opdaterer sider. Det er også vigtigt, at du holder det fri for “affald”.

Det vil blandt andet sige 4xx sider, ikke-kanoniske sider, URL’er som omdirigerer til andre sider eller sider, som du har blokeret for indeksering.

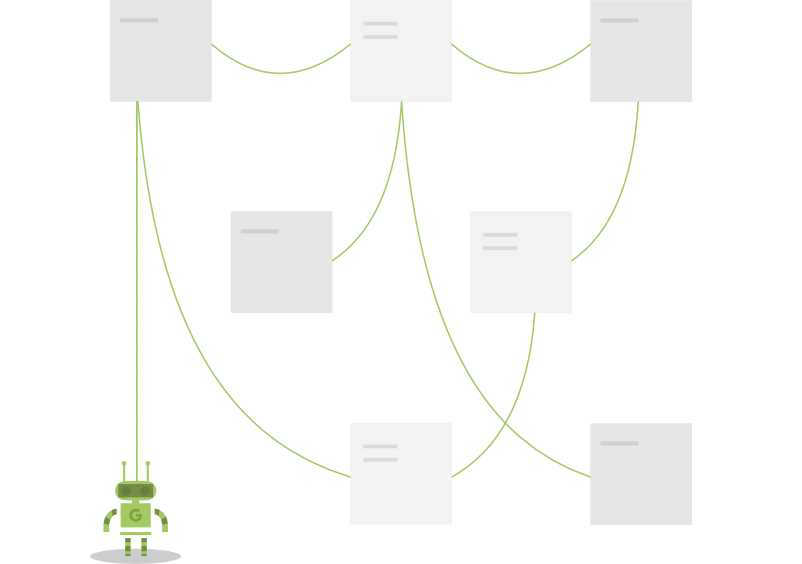

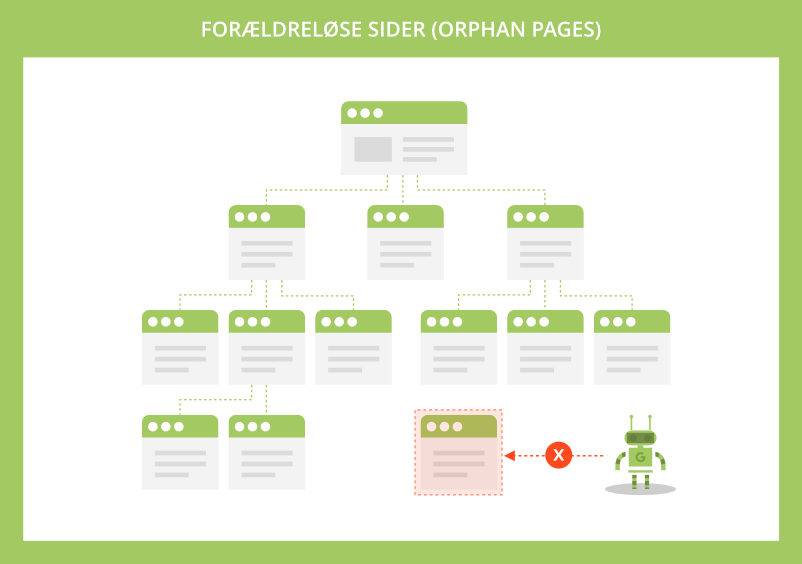

Undgå forældreløse sider

Forældreløse sider (Orphan pages) er “spøgelsessider”, som hverken interne eller eksterne links peger på. Det er derfor enormt svært for Google, at finde disse sider.

I større skala kan forældreløse sider bidrage til større problemer, så som indeksopblæsning og spild af crawl budget. De kan også resultere i, at interne sider konkurrerer med hinanden eller en dårlig brugeroplevelse, hvis de bliver opdaget af brugere organisk.

For at få mest ud af dit crawl budget, skal du sørge for, at der mindst er ét internt link, som peger på hver side på dit website. Og meget gerne også indgående backlinks.

Fortæl Google om dine lokaliserede versioner

Har du et website med indhold på tværs af flere lande og sprog, så bør du fortælle Google om dine lokaliserede sider. Crawlere bruger hreflang tags.

Efter implementeringen bør du også verificere, at du ikke har nogle hreflang-fejl. Du kan bruge rapporten international målretning i Search Console til dette formål. Vent dog lidt tid, så Google har haft tid til at crawle dine sider.

Der findes også flere gode 3. part værktøjer, som du kan bruge til at generere og verificere dine hreflang-tags med.

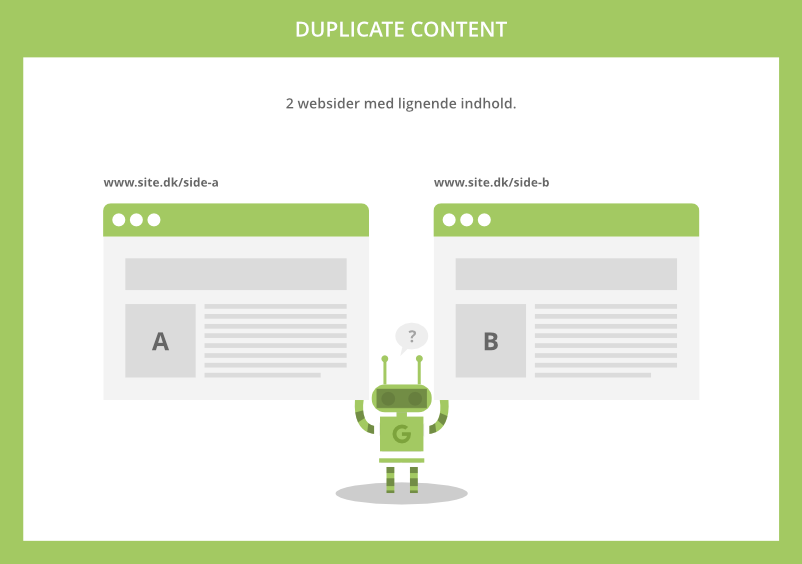

Tynd ud i duplicate content

Duplicate content kan skade dit website på mange måder og det gælder også for dit crawl budget i større skala.

Den korte forklaring er, at Google ikke ønsker at spilde ressourcer på at indeksere flere sider med det samme indhold, som også kan så tvivl om, hvilken side der er originalen.

Du bør derfor sikre, at dine sider er bygget op af unikt indhold med kvalitet. Afhængig af størrelsen på dit website, kan dette være en større eller mindre opgave. Det er dog nødvendigt hvis du vil have mest ud af dit crawlbudget.

Gør livet nemt for Google

Og Google vil belønne dig for det. Google er først og fremmest interesseret i at levere en god brugeroplevelse. Hav derfor dette i din erindring, når du foretager ændringer på dit website. Dermed får du ikke bare mere ud af Googles crawl budget, du forbedrer også brugeroplevelsen på dit website, hvilket ofte leder til øget konvertering.

Teknisk SEO

Lær mere

Godt gået! Du har nu læst guiden "Crawl budget" og er sikkert blevet meget klogere. Du er klar til at kaste dig over den næste lektion.

Flere emner

Linkbuilding

User Experience

SEO værktøjer